商品参数

- 灭菌室有效尺寸: φ388*630mm

- 额定电压: 220V

- 功率: 4.0KW

- 设计压力: 0.28Mpa

- 最高工作压力: 0.22Mpa

- 设计温度: 142℃

- 最高工作温度: 134℃

- 时间设定范围: 0-999min

- 超压自泄保护: 安全阀能释放过高压力

- 超温保护: 超过设计温度灭菌器自动断电

- 漏电保护: 产品出现漏电灭菌器自动断电

- 断水保护: 灭菌器内缺水、低水自动停止工作,报警提示

包装

- 包装单位: 台

- 包装体积: 63.00×61.00×118.00cm

- 毛重: 85.00kg

应用场景

- 应用机构: 其他

- 应用科室: 检验科、传染科、消毒供应室

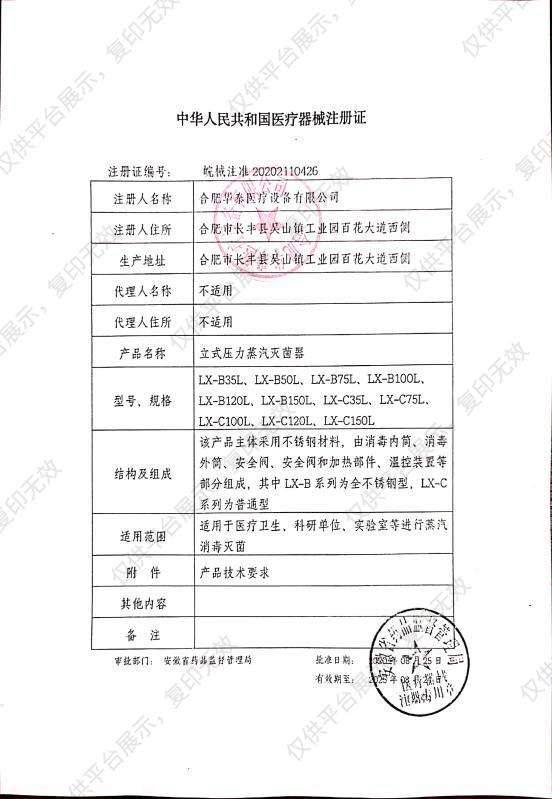

注册信息

- 注册证号: 皖械注准20202110426

- 通用名称: 立式压力蒸汽灭菌器

华泰 立式压力蒸汽灭菌器

LX-B100L(数显型)

产品优势

-

0.22微米空气过滤系统

采用卫生级过滤装置,可有效杜绝灭菌物的二次污染

-

数据记录系统

依据行业标准设计的数据记录系统,可实现灭菌过程地完整追溯

-

过流过压保护系统

经过专业设计和试验的电路保护系统,在网电源发生异常时可有效保护设备

-

多种类高性能控制系统

采用工业级芯片研发的控制系统,用户可根据需要选择数控、真空等多种运行系统

-

实验网篮(选配)

采用优质不锈钢材料制成的灭菌网篮,可方便放置实验室各类灭菌物,加快灭菌过程

产品参数

- 额定电压 220V

- 功率 4.0KW

- 设计压力 0.28Mpa

- 工作压力 0.22Mpa

- 设计温度 142℃

- 工作温度 134℃

- 时间设定范围 0-999min

产品细节

- 01

LED 双排数码管显示灭菌温度和时间

- 02

PID 微电脑控制系统,精准控温控时

- 03

微电脑控制系统,自动排出冷空气和完成灭菌过程

- 04

自动下排式结构排气使灭菌效果更彻底,排冷空气和放气是自动的无需人员操作

使用方法

应用科室

消毒供应室、检验室、实验室等

配置清单

序号

配置名称

数量/单位

1

显示屏

1

2

门锁

1

3

脚轮

4

温馨提示

1.该产品可能含有禁忌内容或者注意事项,具体详见说明书;

2.购买家用医疗器械,消费者应仔细阅读产品说明书或者在医务人员的指导下购买和使用。

华泰 立式压力蒸汽灭菌器 LX-B100L(数显型) 注册证

华泰 立式压力蒸汽灭菌器 LX-B100L(数显型) 注册证