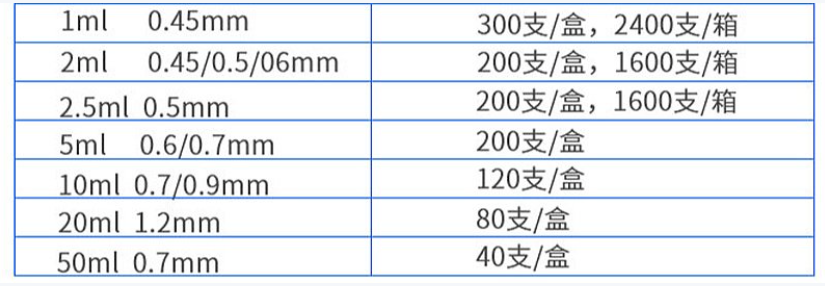

包装

- 包装规格: 200支/盒

- 最小订货量: 2盒

售后服务

- 退货政策 是否支持退货: 支持退货条件: 质量问题退货期限: 7天(从终端签收时间开始计算)

- 换货政策 是否支持换货: 支持换货条件: 质量问题换货期限: 15天(从终端签收时间开始计算)

应用场景

- 应用机构: 二级医院、其他

- 应用科室: 全科门诊、普通病房、普外科、急诊科、康复科、美容科、输液中心

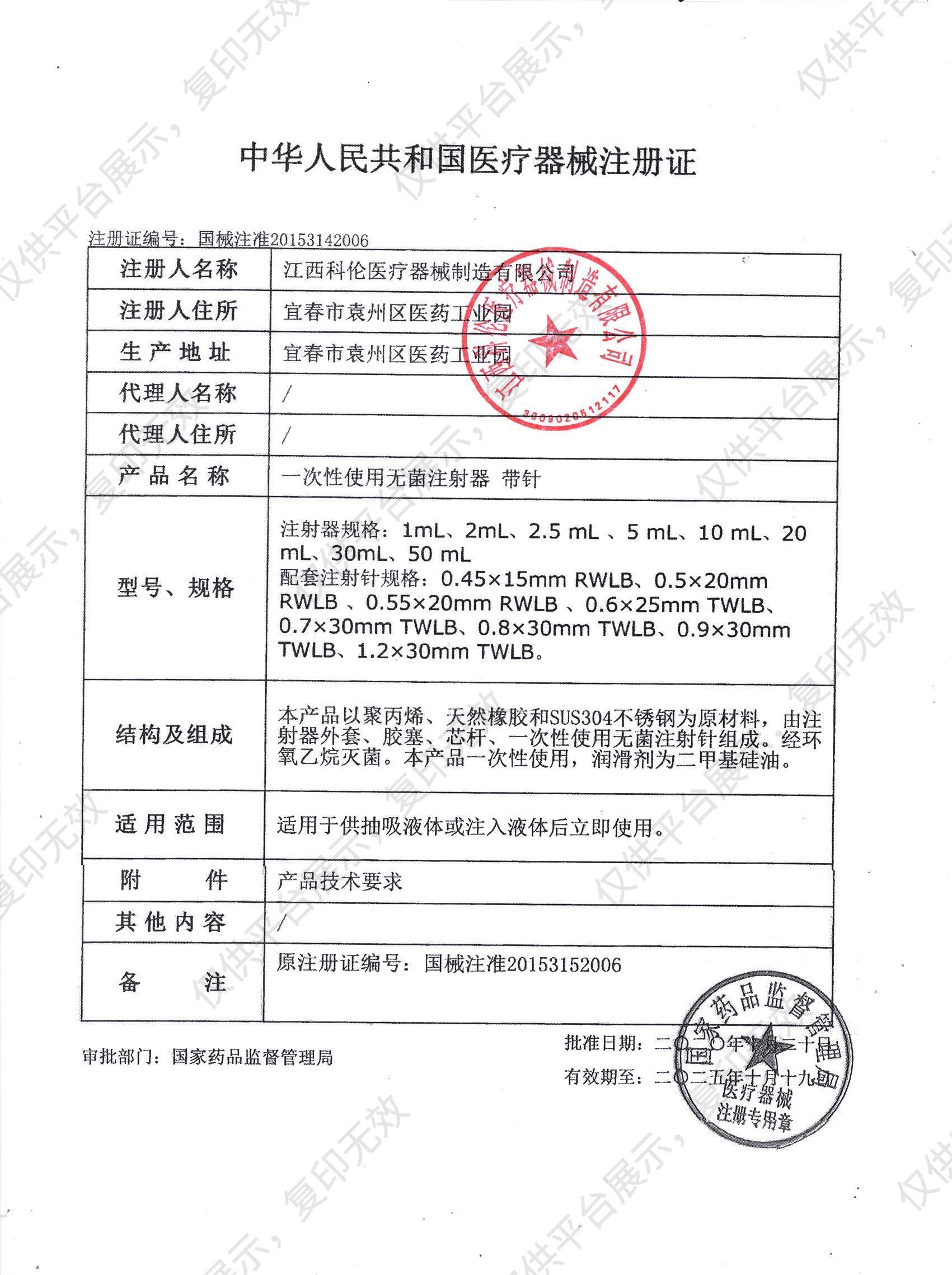

注册信息

- 注册证号: 国械注准20153142006

- 通用名称: 一次性使用无菌注射器 带针

科伦KL 一次性使用无菌注射器 带针

5ml 0.6mm 盒装 (200支)

产品优势

-

材质透明均一

进口医用级粒料,全新注塑工艺,材质透明均一,针尖三面打磨,疼痛刺激轻微,纸塑、透析包装,保护护患健康

产品细节

配置清单

注意事项

- 1、使用前请检查外包装,包装破损禁用;

- 2、过期产品请勿使用;

- 3、本产品为一次性使用产品,不得二次使用;

- 4、使用前将注射针与注射器锥头连接拧紧,防止漏液;

温馨提示

1.该产品可能含有禁忌内容或者注意事项,具体详见说明书;

2.购买家用医疗器械,消费者应仔细阅读产品说明书或者在医务人员的指导下购买和使用。

科伦KL 一次性使用无菌注射器 带针5ml 0 注册证

科伦KL 一次性使用无菌注射器 带针5ml 0 注册证